A Automattic, empresa por trás do WordPress e do Tumblr, está planejando discussões para monetizar o conteúdo dos usuários, vendendo seus dados para empresas de inteligência artificial, incluindo MidJourney e OpenAI. Esses dados das plataformas de blogs Tumblr e WordPress.com serão usados para treinar modelos de IA.

Embora os detalhes da transação ainda não estejam claros, essa notícia levantou preocupações entre os usuários quanto ao possível uso indevido de seu conteúdo privado nas duas plataformas de blogs. Além disso, a 404 Media sugere que houve conflitos internos dentro da Automattic, pois o conteúdo coletado inclui dados privados que não eram destinados a ser retidos dentro da empresa.

Em resposta às reações negativas, a Automattic planeja introduzir uma nova funcionalidade que permitirá aos usuários optar por não compartilhar seus dados para o treinamento de IA. Em uma postagem no blog, a empresa reafirma seu compromisso de fornecer aos usuários do Tumblr e do WordPress um maior controle sobre seu conteúdo. Menciona o lançamento de uma configuração para "desencorajar a exploração por empresas de IA", explicando que as principais plataformas de exploração de IA são bloqueadas por padrão.

O problema do uso do conteúdo de blogs por empresas que desenvolvem modelos de IA não se limita às plataformas gerenciadas pela Automattic. Tanto a OpenAI quanto o Google usam robôs rastreadores para coletar informações de todos os sites para treinar modelos de inteligência artificial. O processo é semelhante à coleta de dados pelos mecanismos de busca.

Como você pode bloquear a OpenAI e o Gemini (Bard) de obter dados do seu blog?

Se você é proprietário de um blog ou site e não deseja que seus dados sejam usados para treinar os modelos de inteligência artificial da OpenAI e do Gemini, você pode bloquear o acesso dos robôs (rastreadores) ao conteúdo. Essa restrição pode ser implementada por meio do arquivo robots.txt.

OpenAI Crawlers

User-agent: GPTBot

Disallow: /Gemini Crawlers

User-agent: Google-Extended

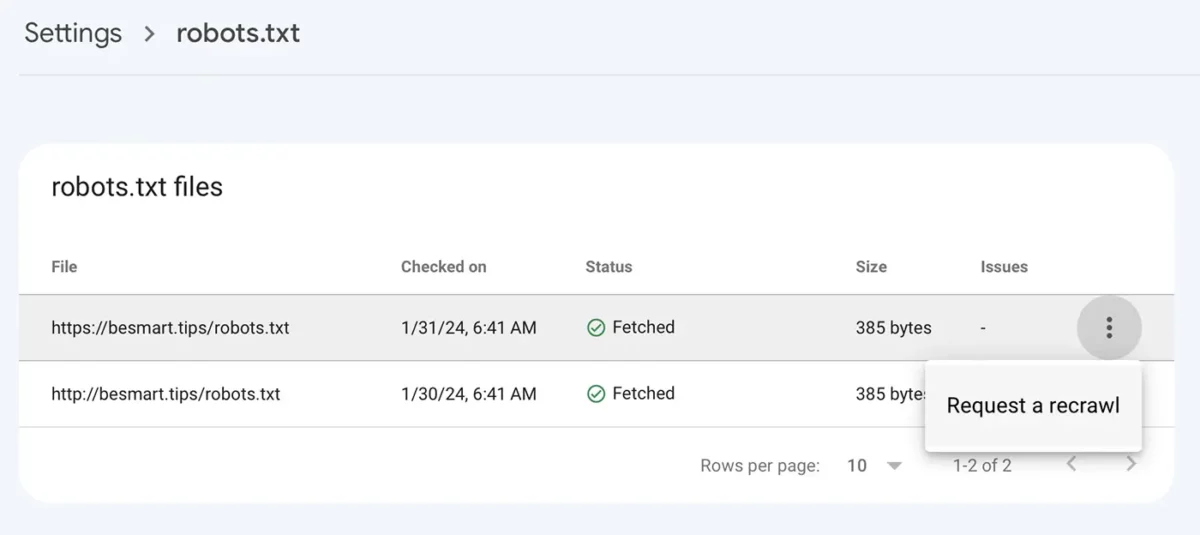

Disallow: /Depois de salvar o arquivo robots.txt com as novas linhas, vá para o Google Console em: Configurações > robots.txt > clique no menu com os três pontos, clique em "Solicitar uma nova verificação".

Relacionado: GPT-5 e o novo web crawler GPTBot desenvolvido pela OpenAI.

Para os usuários do Tumblr e do WordPress, o acesso à recuperação de dados dos blogs pela OpenAI ou outras empresas que desenvolvem inteligência artificial pode ser bloqueado por meio das ferramentas fornecidas pela Automattic.